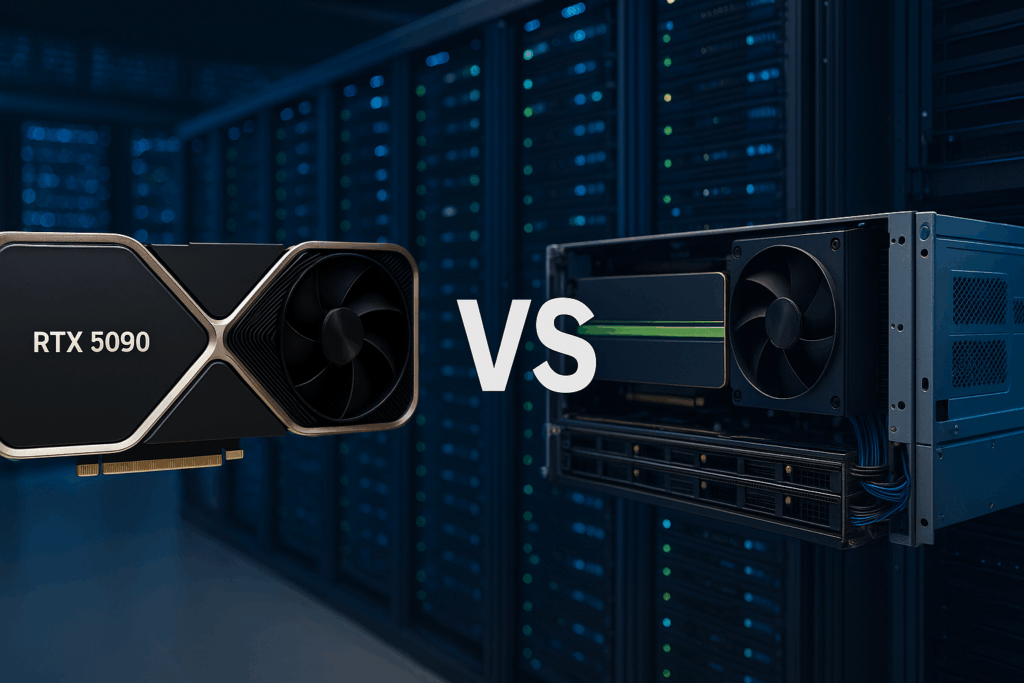

在人工智能与高性能计算日益加速的时代,服务器的显卡配置成为影响科研效率和成本效益的关键因素。“AI训练服务器显卡配置”已成为科研单位和AI企业重点关注的问题。那么,在消费级显卡不断升级的背景下,如刚发布的 NVIDIA RTX 5090,是否能替代专业级算力卡(如 A100、H100)完成深度学习、科学计算等任务?“网昱算力”将从硬件参数、应用场景、长期ROI等维度,进行深度对比与选型建议。

一、核心参数对比:RTX 5090 vs A100 / H100 #

| 参数 | RTX 5090(消费级) | A100(专业级) | H100(专业级) |

|---|---|---|---|

| GPU架构 | Ada Lovelace(预计) | Ampere | Hopper |

| 显存 | 32GB GDDR7(预计) | 40GB / 80GB HBM2e | 80GB HBM3 |

| 内存带宽 | 1.5 TB/s(预计) | 2.0 TB/s | 3.35 TB/s |

| FP32性能 | 100 TFLOPs+ | 19.5 TFLOPs | 60 TFLOPs |

| Tensor性能 | 无专门优化 | 312 TFLOPs(FP16) | 1000+ TFLOPs(FP8) |

| ECC校验 | 无 | 支持 | 支持 |

| 多卡部署 | 性能不稳定 | NVLink支持 | NVLink/NVSwitch支持 |

| 驱动支持 | GeForce Studio | NVIDIA Enterprise | NVIDIA Enterprise |

👉 结论:RTX 5090 拥有出色的浮点性能和极高的性价比,但在稳定性、扩展性、专业驱动、显存带宽等关键科研指标上,仍难以匹敌 A100 或 H100。

二、典型场景分析:科研团队如何选? #

✅ RTX 5090 更适合: #

- 中小型AI模型训练

- AI初创企业 POC 项目

- 科研单位学生实验用机

- 多媒体处理、视频渲染类工作站

- 预算有限但需高性能图形卡的个人或小组

📌 例如使用 PyTorch 进行中等规模 LLM 训练(参数<1B)、图像识别模型Fine-tune等任务,RTX 5090 已能满足初级需求。

✅ A100 / H100 更适合: #

- 大模型预训练与推理部署

- 多卡并行集群部署(NVLink)

- 精度要求极高的科学模拟、分子动力学

- 数据中心级稳定性与运维支持

- 需要完整支持 NVIDIA Enterprise AI 软件栈(NVIDIA NGC)

📌 如高校生物医药实验室进行蛋白质结构预测,或政务机构在做AI推理与安全分析建模,必须考虑专业卡的长期性能与维护。

三、从采购预算看性价比 #

| 类型 | 单卡价格区间(市场价) | 单位算力性价比 | 售后 & 稳定性 | ROI周期 |

|---|---|---|---|---|

| RTX 5090 | ¥15,000 – ¥20,000 | ✅极高 | ❌民用卡,稳定性差 | 适合短期 |

| A100 | ¥70,000 – ¥110,000 | ✅中等 | ✅企业级稳定性 | 适合长期部署 |

| H100 | ¥120,000 – ¥180,000 | ❌昂贵 | ✅顶级 | 超大模型或财力雄厚者适配 |

四、网昱建议:如何为AI训练选购算力服务器? #

作为专业的高校科研与AI企业服务器方案提供商,网昱算力在上百所高校与研究机构中,积累了丰富的实战经验。我们建议:

✅ 预算有限但任务明确:采用多张 RTX 5090 并行部署,辅以强大主板散热与稳定电源系统,搭建入门级深度学习服务器,推荐“网昱 P500 系列工作站”。

✅ 对任务稳定性/精度有要求:建议选择 A100/H100 构建专业级 GPU 服务器平台,可支持主流 AI 框架如 TensorFlow、PyTorch、MindSpore 等,推荐“网昱 H600 系列服务器”。

五、技术选型没有绝对,需求决定最优 #

在显卡技术飞速演进的时代,正确理解 AI训练服务器显卡配置 的差异,是提升项目效率与预算效益的关键。消费级卡如 RTX 5090 适合轻量级AI任务,专业级卡如 A100/H100 则是重载科研与企业部署的“战斗力核心”。

网昱将继续以用户需求为导向,提供包含服务器定制、GPU部署、售后服务的一站式算力解决方案,助力科研与AI项目更高效起飞。