大家好,我是网昱算力的强哥。最近不少客户问我:“DGX、HGX、MGX 这三个平台到底有何区别?企业该怎么选?”名字相似,但定位和适用范围完全不同,弄错了不仅浪费钱,还可能拖慢项目进度。今天我就结合行业实践,把这三个平台逐一拆开,讲透它们的特点与差异。

DGX:官方一体化的旗舰整机 #

硬件层面 #

DGX 是英伟达官方打造的全栈式一体机,最大的优势是软硬件高度集成,买回去就能直接用。在硬件设计上,它始终采用最顶级的 GPU 组合。比如 DGX B200 内置 8 颗 Blackwell 架构的 B200 GPU,上一代 DGX H100 则搭载了 8 颗 Hopper 架构的 H100 GPU。所有 GPU 之间通过 NVLink 4.0 高速互联,单机带宽达到 900GB/s,远远高于传统 PCIe 通道,保证大模型训练时数据传输不卡顿。再配合双路至强或 EPYC 的旗舰 CPU 与 TB 级内存,DGX 能稳定支撑起海量数据输入输出。

软件生态 #

DGX 不仅是硬件堆料,更重要的是出厂就配好了一整套软件环境。CUDA、cuDNN、TensorRT 等工具全部预装,还针对 PyTorch、TensorFlow 等框架进行了深度优化。用户拿到机器后可以直接运行模型,无需重新配置。英伟达还在 NGC 容器库中提供了超过一百种开箱即用的模型,企业只需根据需求进行微调,就能快速进入实战阶段。

部署体验 #

DGX 的部署体验几乎是无可挑剔的。硬件调优、驱动兼容、系统环境这些麻烦事都已经由英伟达工程师在出厂前处理妥当。企业收到设备后,放进机房插上电源,就能通过简单操作立即开展训练任务。对于初创公司而言,这意味着原本需要数周才能完成的准备工作,如今可能在一天之内就能完成。

应用场景与案例 #

DGX 的适用人群非常明确。它适合那些急于启动大模型研发的初创公司,也适合缺少专业运维人员的高校和科研实验室,更适合对稳定性和可靠性要求极高的金融和医疗行业。

我曾服务过一家医疗影像创业公司,团队里都是算法博士和医生,但没有人会搭服务器。他们采购了一台 DGX H100,当天开机就开始训练 CT 影像识别模型,仅用了两周就完成了原型。如果换成自建环境,他们至少要多花两三个月时间。DGX 帮他们把全部精力投入科研,而不是基础设施。

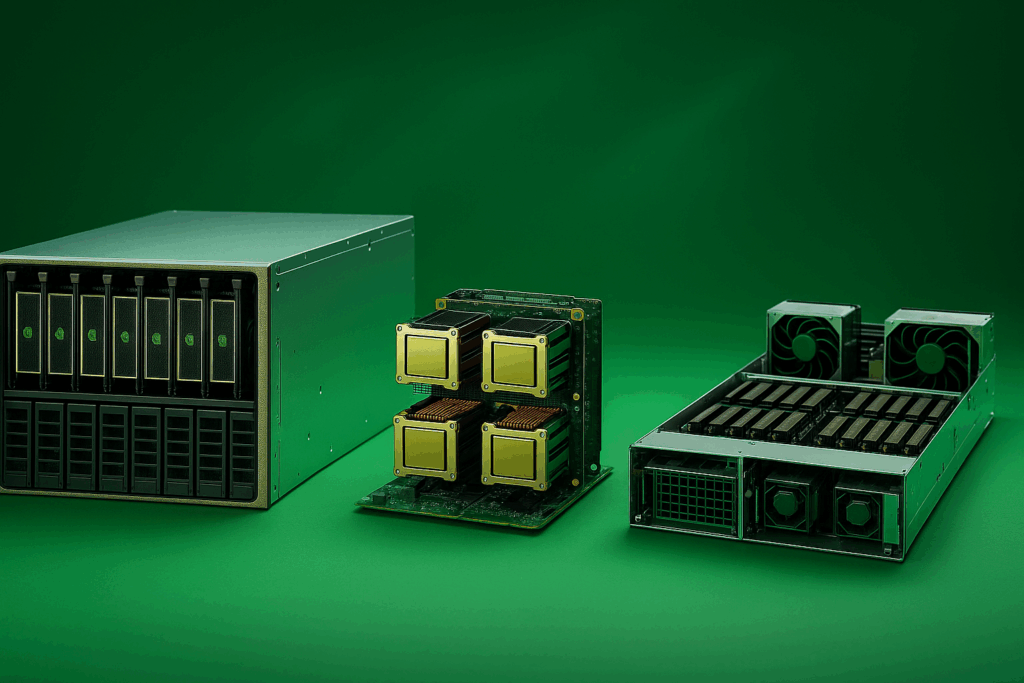

HGX:模块化的定制算力底座 #

硬件层面 #

与 DGX 的“整机即用”不同,HGX 更像是一块 GPU 主板。它为用户提供了算力底座,允许企业或厂商根据业务需求自由搭配 CPU、内存、存储和网络。HGX H100 主板可以支持 4 到 8 张 H100 GPU,并能适配 Intel Xeon 或 AMD EPYC。它同时支持 PCIe 5.0 和 NVLink,高速互联和扩展能力都十分突出。更重要的是,HGX 可以通过 NVSwitch 和 InfiniBand 网络将成千上万颗 GPU 串联成庞大集群,像 Meta、微软等公司部署的大规模 AI 集群就是基于 HGX 构建的。

软件生态 #

英伟达为 HGX 提供底层驱动和 SDK,但具体的软件栈需要用户或厂商自行整合。这种开放性带来了更强的灵活度。科研团队可以针对不同的计算任务,例如分子动力学模拟或 CFD 流体力学,编译出最适合的运行环境,以此发挥出最佳性能。相比 DGX,HGX 在软件层面没有现成的一体化体验,但胜在可深度定制。

部署体验 #

HGX 的部署复杂度高于 DGX。由于它是模块化方案,需要厂商具备较强的集成能力,才能确保硬件、网络和软件环境稳定配合。大多数企业会选择像网昱这样的集成商来完成这一步,从而获得长期稳定可扩展的集群系统。虽然前期投入的精力更多,但带来的灵活性和可扩展性在长期运行中非常有价值。

应用场景与案例 #

HGX 是云计算厂商和大型互联网公司的首选。AWS、阿里云这样的云服务商需要为不同客户提供灵活的算力组合,HGX 能满足他们的定制需求。百度、腾讯这样的公司在建设自有数据中心时,也会大量部署 HGX 来搭建万卡级集群。

我们曾接触过一家自动驾驶企业,他们需要同时进行仿真与模型训练,算力需求极大,但预算有限。如果购买 DGX,单机成本过高无法扩展。最终他们选择基于 HGX H100 架构搭建集群,CPU、内存和存储按照业务特征定制,不仅节省了三分之一的采购费用,还能随着业务增长继续横向扩展,完全符合他们的长期发展计划。

MGX:未来数据中心的标准化算力积木 #

硬件层面 #

MGX 是英伟达最新推出的模块化标准,目标是为超大规模数据中心打造统一规范。它采用了高度标准化的设计,单个机箱最多可容纳 72 张 GPU,是传统服务器密度的三到五倍。MGX 通过共享电源、散热和网络接口的方式提升资源利用率,使得空间与成本效率显著优化。同时,它支持多种 CPU 架构,不仅兼容主流的 x86 处理器,还能运行基于 Arm 的 Grace CPU 与 Grace Hopper 超级芯片,为未来的异构计算奠定基础。

软件生态 #

MGX 在软件层面完全兼容 CUDA 和 NVIDIA AI Enterprise,并且针对 Grace Hopper 平台进行了优化,能够更好地支持 AI 与 HPC 的融合任务。对于需要同时运行大模型训练和科学计算的应用来说,MGX 的软件适配能够充分发挥硬件优势,提高整体能效比。

部署体验 #

MGX 的标准化模块让数据中心的部署效率大幅提升。过去构建一个万卡级集群可能需要几个月时间,而采用 MGX 标准,部署周期能够缩短一半以上。它将原本复杂的定制化工程,转化为类似流水线的模块化拼装,让数据中心扩容更加高效可控。

应用场景与案例 #

MGX 的价值体现在超大规模和绿色算力需求场景。NVIDIA 自己的 DGX SuperPOD 就是基于 MGX 架构打造的超算平台,数以万计的 GPU 高密度集成,支撑全球最大规模的大模型训练。

在实际案例中,我们曾服务过一家大型电信运营商,他们计划建设覆盖全国的 AI 算力网络,既要满足云端训练需求,又要兼顾边缘推理,还必须符合节能减排的政策要求。最终他们采用了 MGX 方案,在核心机房部署高密度 GPU 机箱,在边缘节点配备与 Arm 设备兼容的小型子集群,实现了云边协同。液冷与集中供电技术帮助他们每年节省了数千万电费,同时实现了碳中和目标。

三者横向对比 #

| 维度 | DGX | HGX | MGX |

|---|---|---|---|

| 定位 | 官方旗舰整机 | 模块化 GPU 基板 | 模块化标准架构 |

| 部署效率 | 开箱即用,最省心 | 需厂商/用户集成 | 标准化,部署快 |

| 软件生态 | 全栈预装 | 自行定制 | CUDA+Grace 优化 |

| 扩展性 | 有限 | 极高,适合集群 | 最高,面向未来 |

| 应用场景 | 企业研发、高校实验室 | 云服务商、超算中心 | 超大规模数据中心 |

| 能效 | 高功耗,高性能 | 因厂商差异不同 | 最优,液冷+共享电源 |

| 成本定位 | 高 | 性价比可控 | 高,长期节省运营 |

#

三者的核心差异与选择 #

DGX、HGX 和 MGX 的定位截然不同。DGX 更像一辆随时能开的专车,不需要操心驾驶细节,适合希望快速上手的企业和科研机构。HGX 则像一辆可改装的赛车,用户可以根据预算和需求自由调配,兼顾性能与成本。MGX 则是高铁,强调高密度、能效和规模化,专为超大规模数据中心而生。

DGX 的优势在于省心和稳定,HGX 的价值是灵活与扩展,而 MGX 则代表着未来绿色算力的发展方向。作为长期深耕高性能计算的服务商,网昱 GPU 服务器在 HGX 与 MGX 平台上都有深度优化方案,可以帮助不同客户在不同阶段找到最合适的算力平台,实现快速落地、性能最优和长期节能的综合目标。